Bạn đang tìm kiếm một phương pháp SEO hiệu quả, hợp pháp và dễ thực hiện? Hãy cùng Shabox khám phá bí quyết tối ưu file robots.txt – một “tuyệt chiêu SEO” giúp website của bạn được các công cụ tìm kiếm “ưu ái” hơn. Mặc dù kỹ thuật này không quá phức tạp, nhưng đòi hỏi sự đầu tư thời gian và kiến thức nhất định. Một sai lầm nhỏ trong file robots.txt có thể gây ảnh hưởng tiêu cực đến hiệu suất SEO. Vậy nên, hãy cùng Shabox tìm hiểu chi tiết về file robots.txt và cách tối ưu nó một cách hiệu quả nhé. Trước khi bắt đầu, nếu bạn chưa nắm rõ về SEO, hãy tham khảo bài viết SEO là gì của Shabox.

Robots.txt kiểm soát quá trình thu thập dữ liệu của các công cụ tìm kiếm

Robots.txt kiểm soát quá trình thu thập dữ liệu của các công cụ tìm kiếm

File Robots.txt là gì?

File robots.txt là một file văn bản đơn giản (có đuôi .txt), tuân theo tiêu chuẩn “Robots Exclusion Standard”. Nó hoạt động như một “người gác cổng”, hướng dẫn các công cụ tìm kiếm (như Google) về cách tương tác với website của bạn. Hãy tưởng tượng robots.txt như một bảng quy tắc ứng xử trong một không gian công cộng. Những “người dùng” tốt (các bot tìm kiếm hữu ích) sẽ tuân thủ quy tắc, trong khi những “người dùng” xấu (các bot độc hại) có thể phớt lờ và bị chặn.

Các bot là các chương trình tự động tương tác với website và ứng dụng. Có cả bot tốt và bot xấu. Bot tốt, hay còn gọi là web crawler bot, có nhiệm vụ “crawl” (thu thập dữ liệu) website và lập chỉ mục nội dung để hiển thị trong kết quả tìm kiếm. File robots.txt giúp bạn quản lý hoạt động của những trình thu thập dữ liệu này.

Tầm Quan Trọng Của File Robots.txt Trong SEO

Robots.txt đóng vai trò then chốt trong chiến lược SEO. Nó cho phép bạn kiểm soát việc các công cụ tìm kiếm truy cập vào những phần cụ thể nào trên website. Điều này giúp ngăn chặn nội dung trùng lặp, tối ưu hóa quá trình thu thập dữ liệu và cải thiện hiệu suất SEO tổng thể.

Bên cạnh robots.txt, bạn cũng nên tìm hiểu về thẻ Canonical – một phương pháp khác giúp ngăn chặn nội dung trùng lặp, được nhiều chuyên gia SEO tin dùng. Tham khảo thêm bài viết Canonical URL là gì.

Ví dụ: Giả sử bạn có một website thương mại điện tử với các bộ lọc sản phẩm. Việc sử dụng bộ lọc tạo ra nhiều URL khác nhau nhưng nội dung lại tương tự nhau, ví dụ:

https://shabox.com.vn/san-pham?mau-sac=honghttps://shabox.com.vn/san-pham?mau-sac=xanh-la

Điều này có lợi cho người dùng nhưng lại gây khó khăn cho công cụ tìm kiếm vì nó tạo ra nội dung trùng lặp. Bạn có thể sử dụng robots.txt để chặn các công cụ tìm kiếm index những trang này.

Định Dạng Cơ Bản Của File Robots.txt

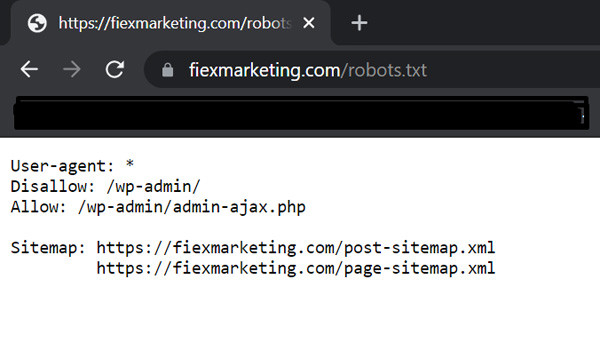

Một file robots.txt cơ bản bao gồm hai dòng:

User-agent: [Tên trình thu thập dữ liệu]

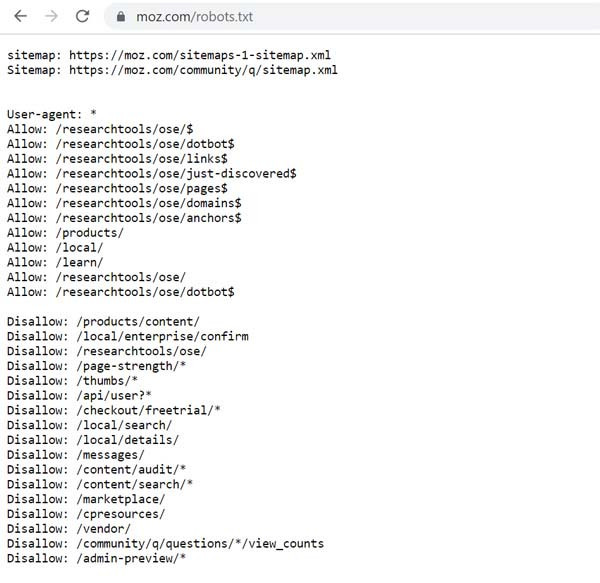

Disallow: [URL không được phép thu thập] Ví dụ về tạo File Robots.txt cho website Moz.com hoàn chỉnh.

Ví dụ về tạo File Robots.txt cho website Moz.com hoàn chỉnh.

Một file robots.txt có thể chứa nhiều user-agent và nhiều chỉ thị khác nhau như Disallow, Allow, Crawl-delay, v.v. Mỗi user-agent được phân tách bằng một dòng trống:

User-agent: *

Disallow: /directory1/

User-agent: googlebot

Disallow: /directory2/

User-agent: anothercrawler

Disallow: /Cú Pháp Phổ Biến Trong File Robots.txt

Dưới đây là các cú pháp quan trọng bạn cần nắm vững:

User-agent

User-agent chỉ định trình thu thập dữ liệu mà bạn muốn hướng dẫn. Ví dụ, nếu bạn chỉ muốn hướng dẫn cho Google hoặc Bing, bạn sẽ sử dụng User-agent: googlebot hoặc User-agent: bingbot.

Một số tùy chọn User-Agent phổ biến nhất trong File Robots.txt chuẩn SEO

Một số tùy chọn User-Agent phổ biến nhất trong File Robots.txt chuẩn SEO

Ký tự đại diện: Dấu sao () được sử dụng làm ký tự đại diện, áp dụng chỉ thị cho tất cả các user-agent: `User-agent: `

Disallow

Disallow yêu cầu công cụ tìm kiếm không thu thập dữ liệu hoặc truy cập vào các trang hoặc thư mục cụ thể. Ví dụ: Disallow: /portfolio/ sẽ chặn truy cập vào thư mục /portfolio/.

Allow

Allow chỉ định các trang hoặc thư mục mà bạn muốn bot truy cập và thu thập dữ liệu. Ví dụ:

User-agent: googlebot

Disallow: /portfolio/

Allow: /portfolio/du-an-dac-biet/Sitemap

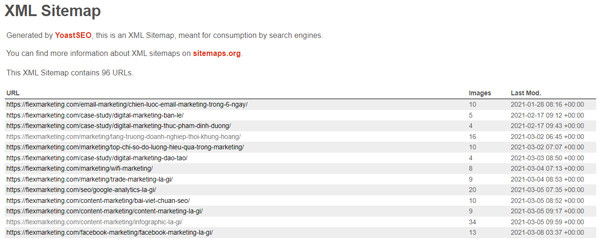

Sitemap cung cấp đường dẫn đến sơ đồ website của bạn, giúp công cụ tìm kiếm dễ dàng thu thập dữ liệu hơn. Ví dụ: Sitemap: https://shabox.com.vn/sitemap.xml

Mẫu sitemap

Mẫu sitemap

Crawl-delay

Crawl-delay yêu cầu bot làm chậm quá trình thu thập dữ liệu. Tuy nhiên, Google và Baidu không hỗ trợ chỉ thị này.

Biểu Thức Chính Quy và Ký Tự Đại Diện

Bạn có thể sử dụng biểu thức chính quy và ký tự đại diện để kiểm soát việc thu thập dữ liệu một cách linh hoạt hơn. Ví dụ: Disallow: /*? sẽ chặn tất cả các URL có chứa dấu hỏi chấm.

Cơ Chế Hoạt Động Của Robots.txt

Các công cụ tìm kiếm khám phá web bằng cách thu thập dữ liệu và theo dõi các liên kết. Trước khi truy cập bất kỳ trang nào trên một domain, công cụ tìm kiếm sẽ kiểm tra file robots.txt của domain đó để biết những URL nào được phép và không được phép truy cập.

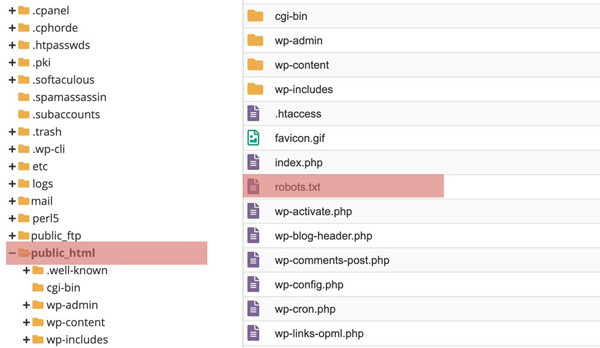

Vị Trí Của File Robots.txt

File robots.txt luôn nằm ở thư mục gốc của domain. Ví dụ: https://shabox.com.vn/robots.txt.

5 Bước Tạo File Robots.txt Cho Website

Bước 1: Tạo File Robots.txt

WordPress thường tạo một file robots.txt ảo. Để chỉnh sửa, bạn cần tạo một file robots.txt vật lý. Bạn có thể làm điều này thông qua plugin SEO (như Yoast SEO hoặc All in One SEO Pack) hoặc qua FTP.

Vị trí của File Robots.txt trong WordPress

Vị trí của File Robots.txt trong WordPress

Ví dụ mẫu về cách tạo robots.txt

Ví dụ mẫu về cách tạo robots.txt

Bước 2: Đặt User-agent

Bạn có thể đặt một hoặc nhiều user-agent, hoặc sử dụng ký tự đại diện (*) để áp dụng cho tất cả.

Bước 3: Đặt Quy Tắc

Sử dụng các chỉ thị Disallow và Allow để đặt quy tắc cho từng user-agent.

Bước 4: Tải Lên File Robots.txt

Tải file robots.txt lên thư mục gốc của website.

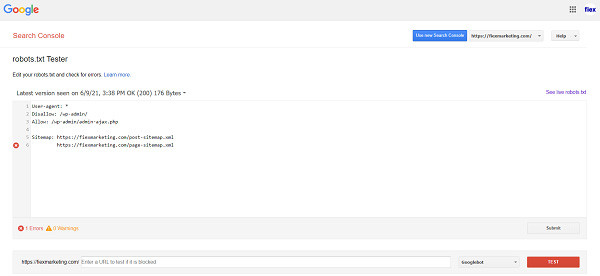

Bước 5: Kiểm Tra File Robots.txt

Sử dụng công cụ kiểm tra robots.txt của Google Search Console hoặc các công cụ khác để kiểm tra lỗi.

Kiểm tra robot.txt

Kiểm tra robot.txt

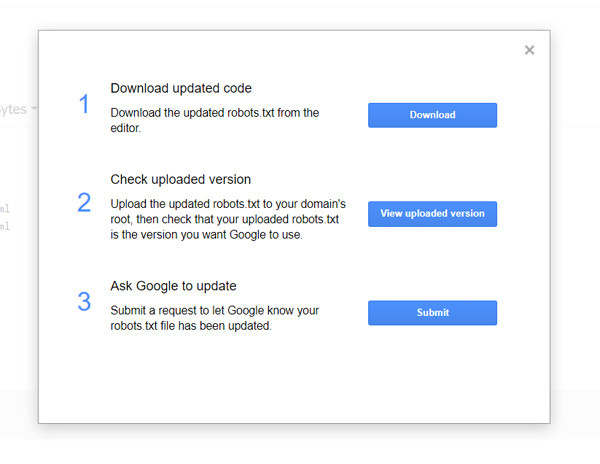

Chọn Ask to Update để gửi

Chọn Ask to Update để gửi

Mẹo Nâng Cao Tối Ưu File Robots.txt

- Thứ tự ưu tiên: Lệnh đầu tiên luôn được ưu tiên.

- Chỉ một nhóm lệnh cho mỗi robot: Tránh gây nhầm lẫn cho công cụ tìm kiếm.

- Càng cụ thể càng tốt: Xác định rõ ràng các chỉ thị

Disallow. - Theo dõi file robots.txt: Đảm bảo file robots.txt luôn được cập nhật.

- Không sử dụng noindex trong robots.txt: Sử dụng meta robots tag hoặc X-Robots-Tag thay thế.

Mẫu File Robots.txt

Có rất nhiều mẫu robots.txt khác nhau tùy thuộc vào nhu cầu của bạn. Bạn có thể tham khảo các ví dụ trong bài viết gốc hoặc tìm kiếm thêm trên internet.

Câu hỏi thường gặp về robots.txt

Bài viết gốc đã cung cấp một số câu hỏi thường gặp về robots.txt. Bạn có thể tham khảo để hiểu rõ hơn về cách hoạt động và ứng dụng của file này.

Kết Luận

Tối ưu file robots.txt là một bước quan trọng trong chiến lược SEO, giúp công cụ tìm kiếm hiểu rõ hơn về website của bạn và cải thiện thứ hạng từ khóa. Hy vọng bài viết này đã cung cấp cho bạn những kiến thức cần thiết về robots.txt.

Về Shabox: Shabox.vn là nền tảng cung cấp kiến thức marketing chuyên sâu, giúp bạn hiểu rõ về các phương pháp kiếm tiền trên mạng, từ chiến lược marketing đến các hình thức kiếm tiền trực tuyến hiệu quả. Chúng tôi cung cấp đa dạng dịch vụ, bao gồm tư vấn chiến lược marketing, đào tạo marketing online, và xây dựng nội dung website. Liên hệ với chúng tôi qua hotline 0977 492 374, email [email protected], hoặc ghé thăm văn phòng tại Số 15, Đường Nguyễn Văn Linh, Phường 4, Quận 7, TP Hồ Chí Minh, Việt Nam.