Việc quản lý cách mà các công cụ tìm kiếm tương tác với website là một yếu tố quan trọng không thể thiếu trong chiến lược SEO. Đặc biệt, file robots.txt chính là công cụ hữu hiệu để hướng dẫn các bot tìm kiếm về những nội dung nào được phép hoặc không được phép crawl (quét). Trong bài viết này, chúng ta sẽ cùng nhau tìm hiểu về file robots.txt, tính năng của nó, cũng như cách tạo và tối ưu file này một cách hiệu quả nhất.

Robots.txt là gì? Hướng dẫn tạo file robots.txt chuẩn chỉnh

Robots.txt là gì? Hướng dẫn tạo file robots.txt chuẩn chỉnh

File robots.txt Là Gì?

File robots.txt là một tệp văn bản nhỏ được đặt ở thư mục gốc của website. Tệp này chứa các chỉ thị hướng dẫn bots của các công cụ tìm kiếm (như Googlebot, Bingbot) về việc các trang nào trên website của bạn được phép hoặc không được phép crawl và lập chỉ mục. File robots.txt là công cụ hữu ích giúp bạn ngăn chặn các công cụ tìm kiếm tiếp cận vào những trang không cần thiết, từ đó bảo vệ thông tin quan trọng và nâng cao trải nghiệm người dùng.

Ví dụ, bạn có thể dùng file robots.txt để chặn các bot tìm kiếm khỏi việc truy cập vào các trang thử nghiệm, hoặc các thư mục chứa tài liệu nội bộ, nhằm tối ưu hóa sức mạnh SEO cho các trang quan trọng.

File robots.txt là gì?

File robots.txt là gì?

Vai Trò Của File robots.txt Đối Với Website

File robots.txt đóng vai trò rất quan trọng trong việc quản lý cách mà bots tiếp cận trang web của bạn. Cụ thể như sau:

- Ngăn Chặn Nội Dung Trùng Lặp: Bằng cách chỉ định URL không nên được lập chỉ mục, bạn có thể hạn chế tình trạng “cannibalization” trong SEO.

- Kiểm Soát Tốc Độ Crawl: Robots.txt giúp ngăn chặn việc server bị quá tải bởi các yêu cầu từ bots, từ đó duy trì hiệu suất website tốt hơn.

- Tiết Kiệm Tài Nguyên Server: Nó giúp bot tập trung vào những phần quan trọng nhất của website, tránh việc truy cập vào các trang không cần thiết, giúp tiết kiệm băng thông và tài nguyên.

Robots.txt

Robots.txt

Cấu Trúc Cơ Bản Của Một File robots.txt

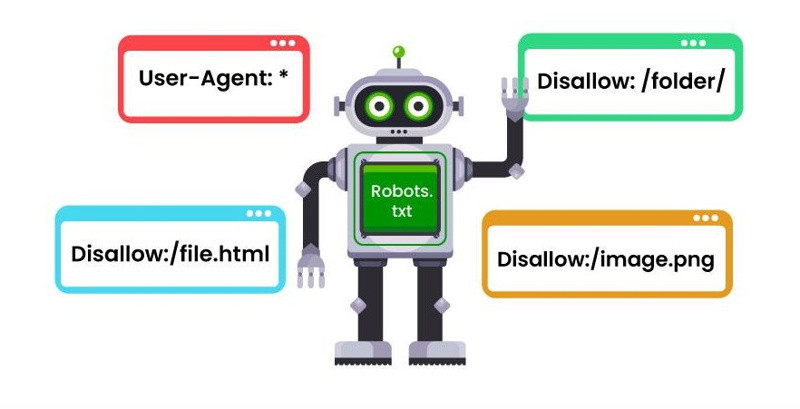

File robots.txt có cấu trúc đơn giản nhưng chứa đựng sức mạnh lớn. Nó gồm các thành phần chính như:

- User-agent: Xác định bot cụ thể mà các quy tắc sẽ áp dụng. Đại diện cho tất cả bots bằng dấu hoa thị (*).

- Disallow: Chỉ định URL hoặc thư mục mà bạn không muốn bot truy cập.

- Allow: Cho phép bots truy cập vào một phần hoặc một URL cụ thể trong thư mục bị cấm.

- Crawl-delay: Đặt thời gian mà các bots nên đợi giữa các yêu cầu đến server.

- Sitemap: Chỉ ra vị trí của bản đồ trang (sitemap) để bot tìm thấy và hiểu cấu trúc của website dễ hơn.

- Các Chỉ Thị Khác: Ví dụ như “noindex” hoặc “nofollow”.

File Robots.txt

File Robots.txt

Ví Dụ Về File robots.txt Chuẩn

Dưới đây là ví dụ về cấu trúc của một file robots.txt chuẩn:

User-agent: *

Disallow: /private/

Allow: /private/special.html

Crawl-delay: 10

Sitemap: https://www.example.com/sitemap.xmlTrong ví dụ này, file chỉ định tất cả các bots không được truy cập vào thư mục /private/, nhưng cho phép truy cập vào trang special.html trong đó. File cũng yêu cầu bots chờ 10 giây giữa các lần truy cập và chỉ định vị trí của sitemap.

Hướng dẫn tạo Robots.txt

Hướng dẫn tạo Robots.txt

Làm Thế Nào Để Kiểm Tra Website Đã Có File robots.txt Chưa?

Cách đơn giản nhất để kiểm tra sự tồn tại của file robots.txt là:

1. Truy Cập Trực Tiếp

Thêm /robots.txt vào sau domain của website bạn (vd: https://www.example.com/robots.txt). Nếu file tồn tại, bạn sẽ thấy nội dung của nó. Ngược lại, bạn sẽ nhận được thông báo lỗi.

2. Sử Dụng Công Cụ Kiểm Tra robots.txt Của Google

Bằng cách đăng nhập vào Google Search Console, bạn có thể xác thực sự tồn tại của file và kiểm tra tính hợp lệ của nó.

Robots.txt Google

Robots.txt Google

Hướng Dẫn Tạo File robots.txt Cho Website Nhanh Chóng, Dễ Dàng

Tạo file robots.txt không khó, đây là bước thực hiện chi tiết:

Bước 1. Tạo File Văn Bản Mới

Sử dụng trình soạn thảo văn bản đơn giản như Notepad hoặc TextEdit để tạo một file mới với tên robots.txt.

Bước 2. Bắt Đầu Với User-agent

Nhập User-agent: * để chỉ định rằng các quy tắc áp dụng cho tất cả bots.

Bước 3. Thêm Các Chỉ Thị Disallow

Nhập các URL hoặc thư mục mà bạn không muốn bots crawl. Nhiều dòng Disallow có thể được thêm vào để kiểm soát việc thu thập dữ liệu.

Bước 4. Thêm Các Chỉ Thị Allow (nếu cần)

Cho phép bots truy cập vào một số trang cụ thể trong thư mục bị cấm.

Bước 5. Thêm Crawl-delay (Tùy Chọn)

Nếu bạn muốn kiểm soát tốc độ crawl, thêm Crawl-delay: 10.

Bước 6. Thêm Đường Dẫn Đến Sitemap

Chèn liên kết đến sitemap của bạn trong file robots.txt.

Bước 7. Lưu File robots.txt Vào Thư Mục Gốc

File phải được lưu ở thư mục gốc của website (thường là /public_html/ hoặc /www/).

Cách Submit Và Xác Nhận Tính Hợp Lệ Cho File robots.txt

Để công cụ tìm kiếm nhận thấy và thực hiện đúng chỉ thị trong file robots.txt, bạn cần:

1. Hướng Dẫn Submit File robots.txt

Tải file đã tạo lên thư mục gốc của website thông qua FTP.

2. Xác Nhận Tính Hợp Lệ

Sử dụng công cụ kiểm tra ính hợp lệ của Google Search Console để đảm bảo file hoạt động đúng.

File Robots.txt

File Robots.txt

Những Quy Tắc Quan Trọng Cần Lưu Ý Khi Tạo Và Sử Dụng robots.txt

- Cẩn Thận Khi Chặn Nội Dung: Không chặn những trang quan trọng ảnh hưởng đến SEO.

- Không An Toàn Cho Dữ Liệu Nhạy Cảm: Không dùng robots.txt để bảo vệ thông tin nhạy cảm, hãy sử dụng phương pháp khác như

noindex. - Nhiều Loại Bot Khác Nhau: Nhận diện các loại bot và tối ưu hóa quy tắc cho từng loại.

Lưu ý khi tạo file Robots.txt

Lưu ý khi tạo file Robots.txt

Một Số Câu Hỏi Thường Gặp Về File robots.txt

1. Robots.txt Có Thể Cài Đặt Trên Website WordPress Không?

Có, bạn có thể dễ dàng tạo robots.txt trên WordPress thông qua các plugin hoặc cài đặt thủ công.

2. File robots.txt Thường Nằm Ở Đâu Trên Website?

File luôn được đặt ở thư mục gốc của domain.

3. Tại Sao Google Vẫn Index Một Trang Mặc Dù Đã Chặn Nó Bằng robots.txt?

Google có thể index trang đó nếu có liên kết từ các trang khác trỏ đến nó.

4. Sử Dụng robots.txt File Có Những Hạn Chế Nào?

File này không thể bảo vệ thông tin nhạy cảm và không ngăn chặn hoàn toàn việc index.

5. Mất Bao Lâu Để Các Thay Đổi Trong robots.txt Ảnh Hưởng Đến Kết Quả Tìm Kiếm?

Thời gian ảnh hưởng có thể từ vài ngày đến vài tuần, tùy thuộc vào quy mô thay đổi và tốc độ crawl của Google.

Tóm lại, file robots.txt là một công cụ quan trọng trong quản lý SEO cho website của bạn. Khi bạn thực hiện đúng cách, file này sẽ hỗ trợ tốt cho việc tối ưu hóa quy trình crawl và bảo vệ thông tin nhạy cảm. Hãy đảm bảo rằng bạn hiểu rõ cách tạo và điều chỉnh file robots.txt một cách chính xác để đảm bảo hiệu suất tốt nhất cho website của mình. Đừng quên thường xuyên kiểm tra và cập nhật file này trong chiến lược SEO tổng thể của bạn tại shabox.com.vn.